리만 가설(Riemann Hypothesis) 쉽게 이해하기2: 진짜 쉽게 이해하기

0) 서론

저번 시간에는 오일러 제타 함수와 오일러의 곱 공식 그리고 소수와의 접점을 살펴보았습니다.

이번에는 본격적으로 리만의 사고 과정으로 뛰어들어 볼까요?

1) 재앙의 소수

리만 이전의 수학계에서 소수(Prime Numbers)는 기존의 해석학적 방법론으로 접근하기 어려운 재앙과도 같은 대상이었습니다.

미분? 적분? 소수 앞에서는 아무 소용이 없었습니다.

미분과 적분을 포함한 해석학은 '연속성'을 전제로 하지만, 소수는 불연속적인 자연수 안에서도 '곱셈적 성질'을 띠는 이산적인 대상이었기 때문입니다.

이러한 난제 속에서 카를 프리드리히 가우스(Carl Friedrich Gauss)가 중요한 통찰을 제시합니다.

1792년경, 당시 15세였던 가우스는 소수표를 귀납적으로 분석하여 소수의 분포에 통계적인 경향성이 있음을 발견했습니다.

그는 $x$보다 작은 소수의 개수를 나타내는 함수 $\pi(x)$가 $x$가 증가함에 따라 로그 함수 $\frac{x}{\ln x}$에 점근적으로 수렴한다고 추측했습니다.

이를 수식으로 표현하면 다음과 같습니다.

$$\pi(x) \sim \frac{x}{\ln x}$$

가우스는 이후 이를 보정하여 로그 적분 함수($\text{Li}(x)$)가 더 정확한 근사값임을 제시하였으나, 이는 어디까지나 경험적 데이터에 기반한 '추측'이었을 뿐, 수학적으로 엄밀하게 증명된 '정리(Theorem)'는 아니었습니다.

그리고 여기서 이 가설을 수학적으로 증명하기 위해 해석학적 도구를 본격적으로 도입한 인물이 바로 가우스의 제자, 베른하르트 리만입니다.

2) 오일러 곱 공식을 보고 '가능!'을 외친 리만

당시 리만이 주목한 것은 선배 수학자 오일러가 남긴 오일러 곱 공식이었습니다. 이것은 소수 연구에 있어서 유일한 예외이자, 희망이었습니다.

$$\sum_{n=1}^{\infty} \frac{1}{n^s} = \prod_{p} \left( \frac{1}{1 - p^{-s}} \right)$$

리만은 이 식의 좌변과 우변이 가지는 본질적인 차이에 주목했습니다.

- 좌변(무한급수): 자연수의 덧셈으로 이루어진, 미분과 적분이 가능한 '해석학(질서)의 세계'

- 우변(무한곱): 소수의 곱셈으로만 이루어진, 불규칙하고 다루기 힘든 '정수론(혼돈)의 세계'

리만이 천재라고 불리는 이유는, 이 등식을 단순한 계산 결과로 보지 않고 서로 다른 두 세계를 잇는 통로로 인식했기 때문입니다. 그의 통찰을 글로 옮기면 다음과 같았을 것입니다.

"이것은 그냥 신기한 등식이 아니다. 수학 전체를 통틀어 질서의 세계와 혼돈의 세계를 연결하는 유일한 다리(bridge)다. 소수의 비밀을 파헤치려면, 우리는 반드시 이 다리를 건너야만 한다. 다른 길은 존재하지 않는다. 나라면 할수있다 나라면! 가능!!!!"

리만에게 제타 함수는 단순한 호기심의 대상이 아니었습니다. 소수라는 견고한 성을 무너뜨리기 위해 반드시 넘어야 할, 유일하고도 필연적인 공성 무기였던 셈입니다.

3) 리만, 오일러 제타 함수를 갈고 닦는다!

이 식의 본질을 깨달은 리만.

결국 우변의 '소수의 비밀'을 완벽히 파헤치기 위해선 좌변을 '완벽하게 분석'해야 함을 알게됩니다.

그리고 '완벽하게 분석'한다는 말인즉슨 현재 s>1인 상황에서만 정의된 오일러 제타함수가 아닌, s가 '모든 수'를 다 아우를 수 있는 '복소수'영역으로 확장되어야 한다는 말인 것이죠.

그리고 사실상 s>1인 영역은 그저 '실수'에서 '복소수'로 확장만 시켜주면 되니 매우 쉬웠습니다.

그러나 여기서 문제는 '복소수 전체 영역'으로 확장해야 한다는 점에 있었습니다.

현재 오일러 제타 함수에서는 s가 1보다 작거나 같은 경우 '무조건 발산'하여 아예 그쪽은 쳐다도 보지 않고 있었습니다.

그러나 리만은 이것을 넘어 '복소수 전체'로 확장해야 하는 필요성이 있었죠.

결국 리만은 s>1에서만 정의되는 오일러 제타 함수를 해석적 연속(혹은 해석적 확장, Analytic continuation)이라는 방법을 통해 s=1을 제외한(s=1에서는 발산) 복소수 전체로 확장시키고 리만 제타 함수라고 이름을 붙입니다.

해석적 연속(Analytic continuation)이란 "함수를 연속이면서 미분가능하게 확장시키는 것"으로 수학자들이 자주사용하는 테크닉입니다.(자연수에서만 정의된 팩토리얼도 감마함수라는 형태로 확장이 가능하죠.)

그리고 이 방법을 사용하면 유일한 형태의 확장된 함수를 얻을 수 있습니다.

일단, 해석적 연속의 기본 예시와 함께 리만이 어떻게 해석적 연속을 사용해서 오일러 제타 함수를 리만 제타 함수로 확장시켰는지 살펴보겠습니다.

1. 해석적 확장의 기본 예시 (등비급수)

가장 직관적인 예시는 무한 등비급수입니다. 하나의 함수가 정의된 영역에 따라 어떻게 확장되는지 보여줍니다.

$$\sum_{n=0}^{\infty} x^n = 1 + x + x^2 + \cdots = \frac{1}{1-x}$$

- 좌변 (급수 형태): 오직 $|x| < 1$ (단위 원 내부)인 범위에서만 수렴하고 정의됩니다.

- 우변 (분수 함수 형태): $x = 1$을 제외한 모든 복소 평면($\mathbb{C} \setminus \{1\}$)에서 정의됩니다.(여기서 역슬래시 표현은 '집합에서 제외한다'는 표현입니다)

- 의미: $\frac{1}{1-x}$는 좁은 영역($|x|<1$)에서 정의된 급수를 더 넓은 영역으로 해석적으로 확장(Analytic Continuation)한 결과입니다.

바로 이것이 해석적 연속이죠.

리만도 똑같은 짓을 했습니다. $s>1$에서만 놀던 오일러의 식을 복소수 전체로 확장했더니, 전혀 새로운 모습의 식이 튀어나온 겁니다. 마치 $1+x+x^2...$가 $\frac{1}{1-x}$로 변신한 것처럼요.

그 결과물이 바로 아래의 무시무시해 보이는 함수 방정식입니다. (식은 복잡해 보이지만, 그냥 '확장된 버전'이라고 생각하고 넘어가세요!)

2. 리만 제타 함수의 함수 방정식 (Functional Equation)

리만은 해석적 확장을 통해 제타 함수를 $s=1$을 제외한 전 복소 평면으로 확장시켰고, 다음의 함수 방정식을 유도해냈습니다.

이 식은 $\zeta(s)$와 $\zeta(1-s)$ 사이의 관계를 보여줍니다.

$$\zeta(s) = 2^s \pi^{s-1} \sin\left(\frac{\pi s}{2}\right) \Gamma(1-s) \zeta(1-s)$$

- 구성 요소:

- $2^s, \pi^{s-1}$: 지수 및 파이 항

- $\sin\left(\frac{\pi s}{2}\right)$: 삼각함수 항 (이 항 때문에 음의 짝수에서 자명한 근이 발생함)

- $\Gamma(1-s)$: 감마 함수 (팩토리얼의 일반화)

- $\zeta(1-s)$: 대칭되는 위치의 제타 함수 값

- 대칭성 (Symmetry):

- 이 방정식에 의해 제타 함수는 $s$와 $1-s$가 서로 연결됩니다. 이는 복소 평면 상에서 실수부 $Re(s) = \frac{1}{2}$인 직선(Critical Line)을 축으로 하여 대칭적인 구조를 가짐을 의미합니다.

4) 리만가설 용어 해설

자, 여기까지 약간 조금 깊게 살펴본 것 같으면, 다시 이제 '쉽게 알아보기' 수준으로 다시 올라오도록 하죠.

사실상 원래 이 포스팅의 집필의도가 '엄밀한 수학적 탐구' 보다는 먼저 '리만 가설이 뭔데?'를 쉽게 설명하기 위한 글이었으니까요!

따라서 더 깊게 들어가지는 않고, 이제 여기서 나오는 용어들만 해설하고 마무리 짓도록 하죠.

앞서 보여드린 그 복잡한 식에 $\sin$ 항($\sin(\frac{\pi s}{2})$)이 있었던 거 기억하시나요?

이 $\sin$ 항의 $s$에 음의 짝수($-2, -4, -6, \dots$)를 넣으면, 사인 함수 특성상 무조건 0이 되어버립니다.

곱셈식에서는 어느 한 놈만 0이 되어도 전체 결과가 0이 되죠? ($A \times B \times 0 = 0$ 이니까요!)

즉, 이 근들은 별다른 노력 없이도 식의 구조만 보면 "어? 여기 0 되네?" 하고 바로 찾아낼 수 있습니다.

수학자들은 이렇게 너무 뻔하고 싱겁게 구해지는 근들을 자명한 근(Trivial Zeros)이라고 부릅니다. "야, 이건 볼 것도 없어. 패스해." 하고 치워버리는 거죠.

그렇다면 비자명한 근(Non-trivial Zeros)이란?

바로 저 뻔한 곳(음의 짝수)이 아닌데도 불구하고, 기묘하게 함수값을 0으로 만드는 근들을 말합니다.

리만은 이 근들이야말로 소수의 비밀 정보를 담고 있는 진짜 보물이라고 생각했습니다.

그리고 바로 여기서 우리가 포스팅을 처음 시작하면서 쓴

"리만 제타 함수 $\zeta(s)$의 모든 비자명근(non-trivial zeros)은 실수부가 $\frac{1}{2}$인 직선 위에 있다."

이 말을 이해할 수 있게 됩니다!

즉, "소수의 비밀은 아무 데나 흩어져 있는, 무작위적인 게 아니라, 정확히 $\frac{1}{2}$ 라인에 일렬로 정렬해 있는 규칙이 있다"는 뜻이 됩니다!

5) 그래서 왜 리만가설이요?

재밌는 포인트는... 실제로 리만은 이 비자명근을 네 개까지만 구했습니다.

그리고 "내가 네 개 정도 구해봤는데, 다 실수부가 1/2이던데? 그러니까 앞으로 나오는 모든 근도 다 실수부가 1/2일껄?"하고 넘어갔다는 부분이죠.

이 쿨한(?) 추측이 바로 수학 역사상 가장 거대한 난제, "리만 가설"의 시작이었습니다.

현재 우리는 슈퍼컴퓨터를 돌려서 10조(10 trillion) 개가 넘는 비자명근을 찾아냈습니다.

결과는 어땠을까요? 놀랍게도 10조 개 모두 정확히 $\frac{1}{2}$ 직선 위에 있었습니다. 단 하나의 예외도 없이 말이죠.

또한, 앞서 살펴본 함수 방정식을 통해 근들이 대칭적($\frac{1}{2}$을 기준으로 좌우 대칭)이라는 사실도 이미 증명되었습니다.

"그럼 끝난 거 아니야?"라고 하실 수 있으시겠지만, 아닙니다.

수학에서는 10조 개가 맞아도, 무한대까지 가는 길 어딘가에 숨어 있는 단 하나의 반례(예외)만 있어도 가설은 즉시 거짓이 되어 폐기처분됩니다.

리만 가설은 아직 그 '단 하나'의 예외가 없다는 것을 수학적으로 완벽히 증명하지 못했기에, 여전히 '가설(Hypothesis)'이라는 꼬리표를 달고 있는 것입니다.

그리고 현대 정수론과 암호학의 수많은 정리들이 "리만 가설이 참이라면..."이라는 전제하에 지어져 있습니다.

만약 이 가설이 거짓으로 판명 난다면? 수학계는 그야말로 대혼란(Crisis)에 빠지게 될 겁니다. 수많은 논문이 휴지 조각이 될 테니까요.

6) 소수랑은 무슨 상관?

자, 이제 '리만 가설' 자체는 알아보았는데, '도대체 이 리만 제타함수의 비자명한 근이 소수랑 무슨 연관인데?'에 관해서 궁금하지 않으세요?

앞서 가우스가 소수의 분포를 예측하며 로그 적분 함수($\text{Li}(x)$)를 제안했다고 했었죠?

가우스의 예측은 전체적인 경향성(Trend)을 아주 잘 맞춥니다.

하지만 실제 소수는 이 매끄러운 함수를 따라 얌전하게 움직이지 않습니다.

함수는 '연속적'이지만, 소수는 '이산적'인 존재니까요.

바로 이 지점에서 리만 제타 함수가 등장합니다.

리만은 제타 함수의 비자명한 근($\frac{1}{2}+14.13i \dots$)들이 단순한 숫자가 아니라, 가우스의 예측값과 실제 소수 사이의 간극을 메워주는 '오차 보정항(Correction Term)' 역할을 한다는 것을 밝혀냈습니다.

이것을 우리가 아는 푸리에 변환의 관점에서 보면 소름 돋는 일이 벌어집니다.

제타 함수의 근들을 파동(Wave)으로 바꿔서(푸리에 역변환) 하나씩 더해나가면(중첩시키면), 처음에는 밋밋했던 곡선이 점점 구불구불해지더니...

파동을 10개, 100개, 1000개 더해갈수록 그 구불거림이 점점 날카로워집니다.

그러다 마침내, 정확히 소수가 존재하는 위치($2, 3, 5, 7 \dots$)에서만 그래프가 직각으로 꺾이며 '계단' 모양을 만들어냅니다.(누적 그래프처럼 말이죠!)

-더 나아가기

리만의 명시적 공식(Riemann's Explicit Formula)이라는 것이 있습니다.

개념만 살짝 주워담아 보자면,

1. "곱하기"를 "더하기"로 찢어발기기 (로그의 마법)

오일러의 곱 공식을 다시 봅시다.

$$\zeta(s) = \prod_{p} \frac{1}{1 - p^{-s}}$$

우변은 소수들의 곱(Product)입니다. 수학에서 곱셈 덩어리는 다루기가 까다롭습니다. 미분을 하기도 힘들고, 분석하기도 어렵죠.

그래서 리만은 양변에 자연로그($\ln$)를 취해버립니다. 로그의 성질($\ln(ab) = \ln a + \ln b$) 덕분에 곱셈이 덧셈으로 바뀝니다.

$$\ln \zeta(s) = \sum \text{(소수와 관련된 항들)}$$

이제 우변은 '소수들의 합' 형태가 되었습니다.

즉, 제타 함수($\zeta$)의 정보 = 소수($p$)들의 정보의 합이라는 등식이 성립합니다.

2. 소수의 개수를 '파동'으로 표현하다 (명시적 공식)

리만은 여기서 멈추지 않고, 복소해석학의 도구(유수 정리, 푸리에 역변환 등)를 총동원하여 역사적인 수식을 만들어냅니다.

이것이 바로 "소수의 개수 $\pi(x)$를 제타 함수의 해(Zero, 0이 되는 값)들로 표현하는 공식"입니다.

직관적으로 표현하면 다음과 같습니다.

$$\pi(x) \approx \underbrace{\text{Li}(x)}_{\text{가우스의 예측값}} - \underbrace{\sum_{\rho} \text{Li}(x^{\rho})}_{\text{제타 함수의 0점들에 의한 오차}}$$

- $\pi(x)$: 실제 소수의 개수 (우리가 알고 싶은 것)

- $\text{Li}(x)$: 가우스가 예측한 매끄러운 곡선 (평균)

- $\sum \text{Li}(x^{\rho})$: 제타 함수가 0이 되는 지점($\rho$)들이 만들어내는 파동(오차)

이 식의 의미:

"실제 소수의 분포($\pi(x)$)는 가우스의 예측값에서, 제타 함수의 0점($\rho$)들이 만들어내는 파동들을 빼주면 정확하게 일치한다."

즉, 제타 함수의 0점(Zero)의 위치를 안다는 것은, 소수 분포 그래프가 평균에서 얼마나 출렁거리는지 그 '오차의 파동'을 완벽하게 안다는 뜻이 됩니다. 그러니 필연적으로 소수의 위치가 드러날 수밖에 없는 것이죠.

7) 마무리

자, 이렇게 리만가설을 쉽게 이해해 보았습니다.

이 포스팅은 "리만 가설이 뭔데?"에 초점을 맞춘 것이라 은근히 매우 간단하게 서술되었지만, 실제로 이 가설은 '소수의 근본'을 찾는 과정이라 파려고 들면 진짜 복잡하게 팔 수 있는 부분입니다.

나중에 조금 더 여력이 되면, 조금 더 파보도록 하겠습니다.

'Study > Mathematics' 카테고리의 다른 글

| 리만 가설(Riemann Hypothesis) 쉽게 이해하기1: 오일러 또또 당신이에요? (0) | 2025.11.23 |

|---|---|

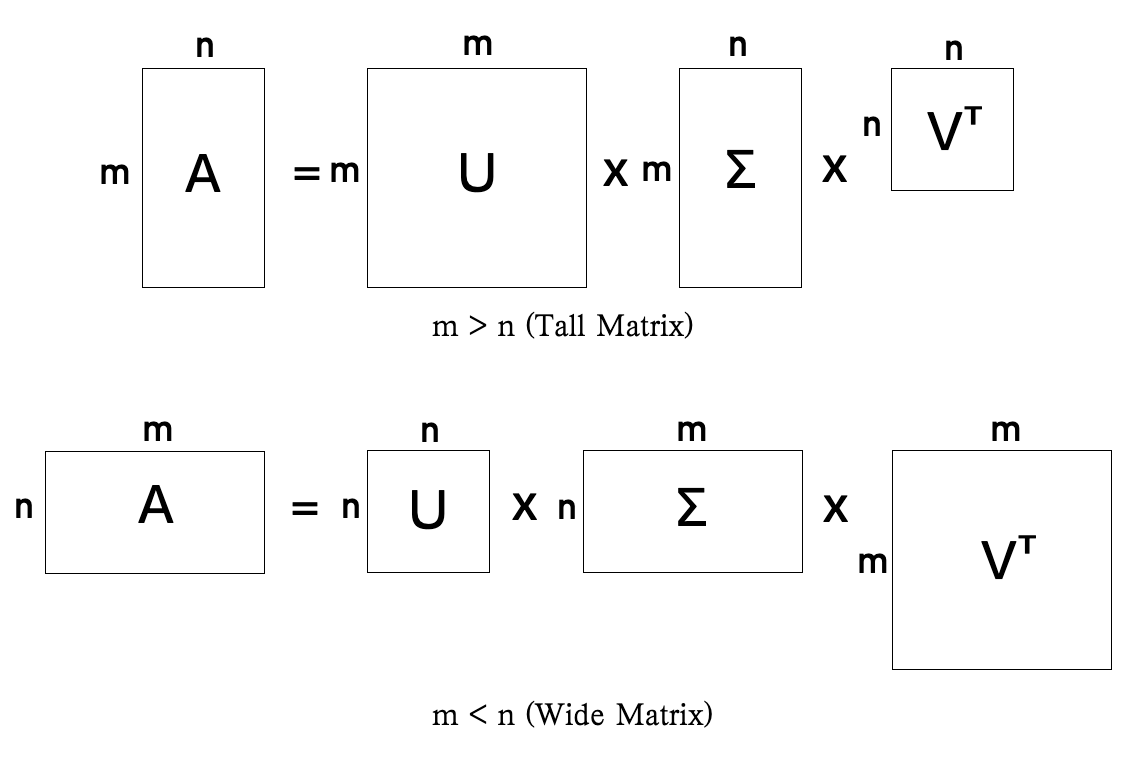

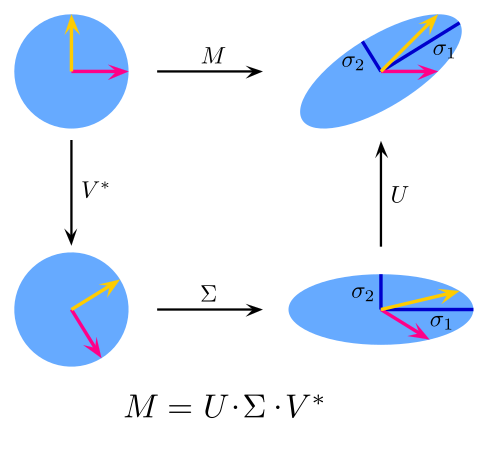

| 특잇값 분해(Singular value decomposition, SVD) - 행렬 기반 접근으로 유도하기 (0) | 2025.11.20 |

| 특잇값 분해(Singular value decomposition, SVD) - 행렬식으로 만들기 (0) | 2025.11.19 |

| 특잇값 분해(Singular value decomposition, SVD) - 뒤틀림 정도 찾기 (0) | 2025.11.18 |

| 특잇값 분해(Singular value decomposition, SVD) - 직교 축 찾기 (0) | 2025.11.17 |